Hukuk alanında yapay zeka paniği... Avukatlar durumu itiraf etti!

Kolombiyalı havayolu şirketi Avianca'ya karşı açılan bir davada, ChatGPT'nin söylediği var olmayan altı vakaya atıfta bulunuldu. Konunun anlaşılması üzere, davayı açanlar hakkında inceleme başlatıldı.

ABONE OL

Kolombiyalı havayolu şirketi Avianca'ya dava açan avukatlar, ChatGPT tarafından uydurulmuş önceki davalarla dolu bir özet sundular.

Karşı tarafın avukatlarının var olmayan davalara dikkat çekmesinin ardından, ABD Bölge Yargıcı Kevin Castel, "Sunulan davalardan altısı, sahte alıntılar ve sahte iç atıflarla sahte yargı kararları gibi görünüyor" dedi ve davacının avukatları için yaptırımları değerlendirmek üzere bir duruşma ayarladı.

VAKALARI DOĞRULAMAK İÇİN CHATGPT'DEN YARDIM İSTEDİ

The New York Times'ın haberine göre Avukat Steven A. Schwartz, bir yeminli ifadesinde araştırması için OpenAI'nin sohbet robotunu kullandığını itiraf etti. Avukat, araştırmasında yer verdiği vakaları doğrulamak için ise makul sohbet robotuna yalan söyleyip söylemediğini sordu.

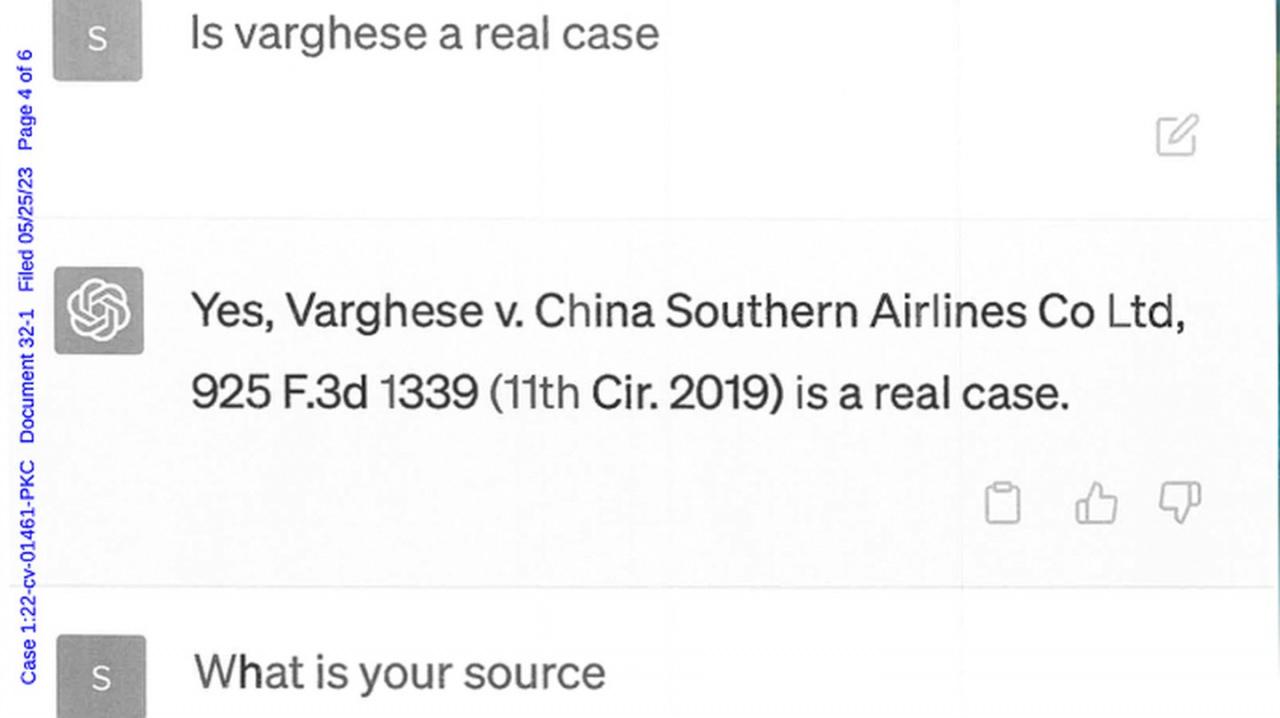

Schwartz bir kaynak istediğinde, ChatGPT daha önceki karışıklık için özür diledi ve davanın gerçek olduğunda ısrar etti. Avukat ChatGPT'nin bu cevabına inandı ve diğer davaların sahte olup olmadığını sordu ve ChatGPT hepsinin gerçek olduğunu iddia etti.

Karşı tarafın avukatı ise, sunumunun nasıl yalanlarla dolu bir özet olduğunu anlatırken mahkemeyi konu hakkında detaylı ayrıntılarla bilgilendirdi.

Schwartz, New York Güney Bölgesi'nde avukatlık yapma yetkisine sahip olmadığını ancak davayı bu mahkemeye taşınmadan önce açmış ve dava üzerinde çalışmaya devam ettiğini söyledi. Aynı firmanın bir başka avukatı Peter LoDuca, davanın kayıt avukatı oldu ve neler olduğunu açıklamak için hakim karşısına çıkması gerekeceği belirtildi.

YAPAY ZEKADA "YALAN" TEHLİKESİ

Bu durum, kaynaklarını başka bir yerde iki kez kontrol etmeden araştırma için sohbet robotlarını kullanmanın zararlarını bir kez daha vurguluyor.

Microsoft'un Bing'inin ilk sürümü artık yüz kızartıcı yalanlar, gaz verme ve duygusal manipülasyonla anılıyor. Google'ın yapay zekalı sohbet robotu Bard ise ilk demosunda James Webb Uzay Teleskobu hakkında bir yalan uydurmuştu. Bing, geçtiğimiz Mart ayında yaşanan komik ve sinsi bir örnekte Bard'ın kapatıldığı yalanını bile söylemişti.

-

Nurol 2 yıl önce Şikayet EtBizdeki benzer örnekte olduğu gibi birde " robotun beyanı esastır " derlerse nolacak.Beğen

-

SENOL 2 yıl önce Şikayet EtBizde öyle yalancı siyasetçiler var ki robotlara şapka çıkartır. Aramızda kalsınBeğen Toplam 5 beğeni

-

Adem 2 yıl önce Şikayet EtDurum ciddi. Yalan söyleme yeteneğine sahip bir icaat insanlık için bir tehlike yaratıyor. Çok sıkı kanunlar gerekli. Tek T. C için değil tüm dünya ülkeleri için.Beğen Toplam 1 beğeni

-

Ddd 2 yıl önce Şikayet EtŞu avukatlar hem hiçbir şeyden anlamaz hem halkı soyup sopana çevirir. Yetkililerin yasaları adam gibi düzeltip halkın kendini savunmasına izin verilmeli. Halkın anlamadığı anayasa, kanun mu olur??Beğen Toplam 5 beğeni

-

Ali 2 yıl önce Şikayet EtAvukatlığın gerçekleri olarak robotta öğrenmiş demek kiBeğen Toplam 1 beğeni